2022年11月16日から3日間に渡って幕張メッセで開催された音、映像、通信のプロフェッショナル展「InterBEE」に、sync.devは初めてブースを出展。当日デモンストレーションを行った2つの自社プロダクトについて、代表の岡田にインタビューいたしました。sync.devの考える自社プロダクト開発の目的や役割について、是非触れてみてください。

市場の反応を見るために、InterBEEへ初出展

ーInterBEEへの出展は今回が初となります。どのような目的があったのでしょうか?

きっかけは、株式会社G-Cal 小枝さんからの「一緒に出展しませんか?」というお声がけです。それなら制作中の自社プロダクトの反応を見てみようと考え、参加することにしました。

今回「dScope」「Gevanni」の2つを選んだのには、いくつか理由があります。ひとつは、プロダクトとして仕上がりつつあったこと。自社プロダクトとしては他にも「InfinityDesk」や「Bethe」などがありますが、要素技術(製品を構成する要素に関する技術)としての色が強く、InfinityDeskに至っては作品と言った方がいいかもしれません。それに比べてdScopeやGevanniは、プロダクトとしての切り出しが可能なレベルまで仕上げられていました。

もうひとつは、他社との差別化ができそうなものであったこと。クラウドスイッチングやバーチャルプロダクションに関するものは、他社が大規模な展示をすることが予想されており、実際もそのようになっていました。市場の反応を見るための参考出展ということを踏まえ、sync.devらしい2つの自社プロダクトで展示を行うことに決めました。

会場ではこのようなフライヤーも配布しました

学びからこぼれ落ちてしまっている「波形モニタ」についての理解を促進 ―リアルタイム3D波形モニタ「dScope」

ーまずは、dScopeについて教えてください。

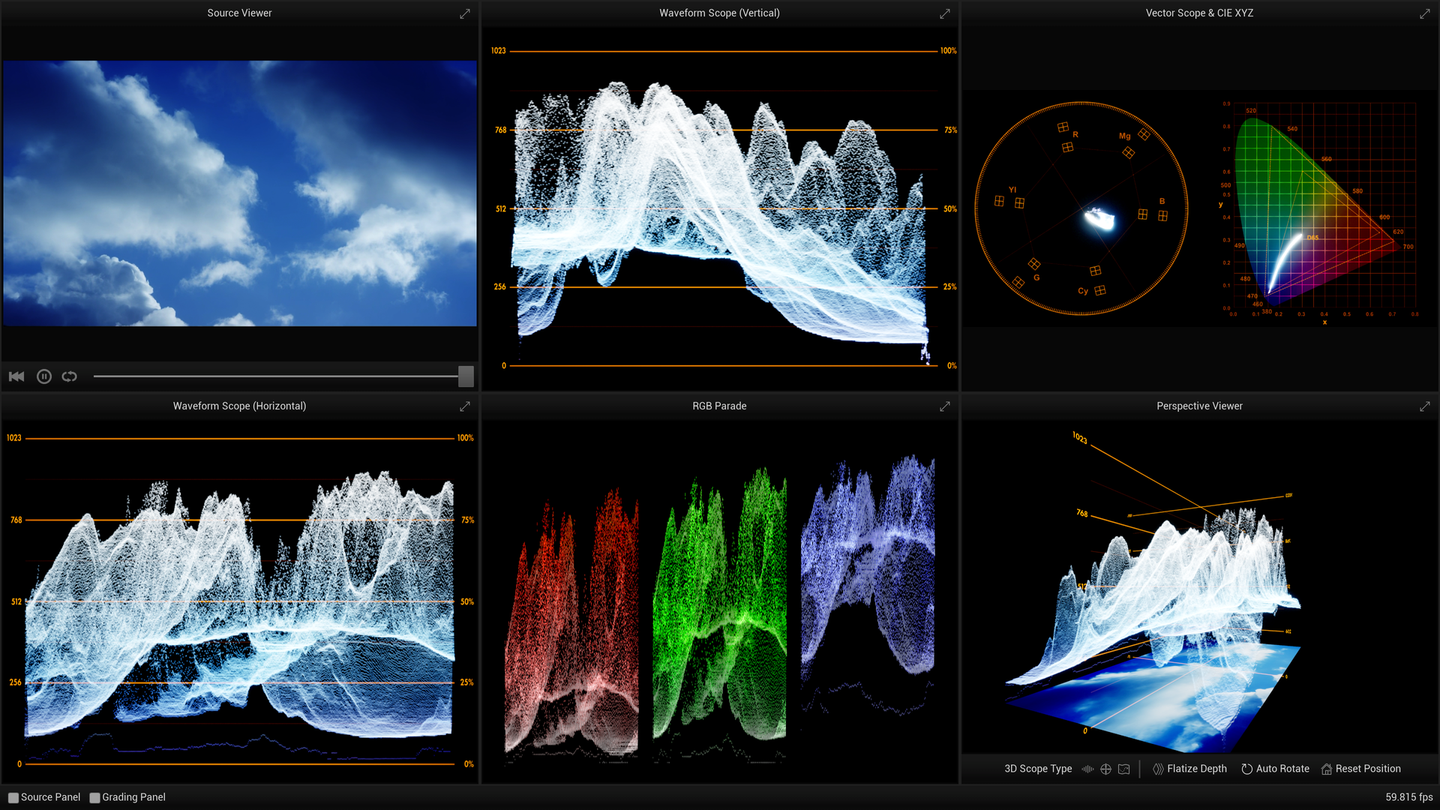

dScopeは「波形モニタの新しい見せ方」を提示するプロダクトです。

波形モニタとは、映像信号の観測に特化したオシロスコープのこと。波形モニタについてはSTUD(岡田が代表を務めるポストプロダクションスタジオ)でも読み方を教えていたのですが、これがなかなか難しく、オンラインMTGが主流になったことでより一層難易度が上がっていました。

言葉で説明するとしたら「画面の縦は明るさに、画面の横は画面そのものの横に対応しており、画面の縦は奥行きに変換されている」なんですが、この説明では意味がわからないですよね。でも僕たちsync.devが得意としている「データビジュアライズ」の力を活かせば、わかりやすくできるのではないか。そう考えたのが企画の始まりです。

dScopeデモ映像

ー波形モニタが難しいとされるポイントは、特にどのあたりなのでしょうか?

「どうなっていれば正しく、どうなっていると正しくないのか」を理解するのが難しく、読み取るのに経験が必要なことでしょうか。

例えば最近のカメラには、フォーカスのあっている所が赤く縁取りされたり、白飛びしている部分がゼブラでエラー表示されるなどの機能が備わっています。でも一部の高額なものを除き、波形モニタにはそういったガイドのようなものがありません。慣れないと読めないし、慣れるためにはポスプロ(ポストプロダクションスタジオ)に入らなければならず、「鶏が先か、卵が先か」という状態になっているんです。

専門学校でもほとんど教えていないし、ビデオグラファーなど独学でやってきた方が勉強できる機会もなかなか無いため、波形モニタを読める人がどんどん減ってしまっている。そのことに映像業界の人間として危機感を感じたことも、dScopeを開発した理由のひとつです。

ー開発はスムーズにいきましたか?

非常にうまくいきました。普段のワークでもUnreal Engineなどでビジュアライズを行っているので、映像信号とCGの間のインタラクションや座標計算などについてはノウハウを持っており、それが活かせたのではないかと思います。

特に良かったのが、波形上でのエラー部分が大変わかりやすくビジュアライズできたこと。端的にいうと、マッハバンドとピークが切れてしまっているようなケースですね。通常の波形モニタは映像の縦方向が奥行きに変換されたことですべて圧縮されてしまい、怪しい波形があったとしてもそれがどこの部分なのかがわかりにくくなっています。これを頭の中で想像して読み解くには経験が必要でしたが、dScopeなら実際に奥行きとして見ることができるので、どこが破綻しているのか一発で判別できてしまうんです。

dScopeの画面イメージ

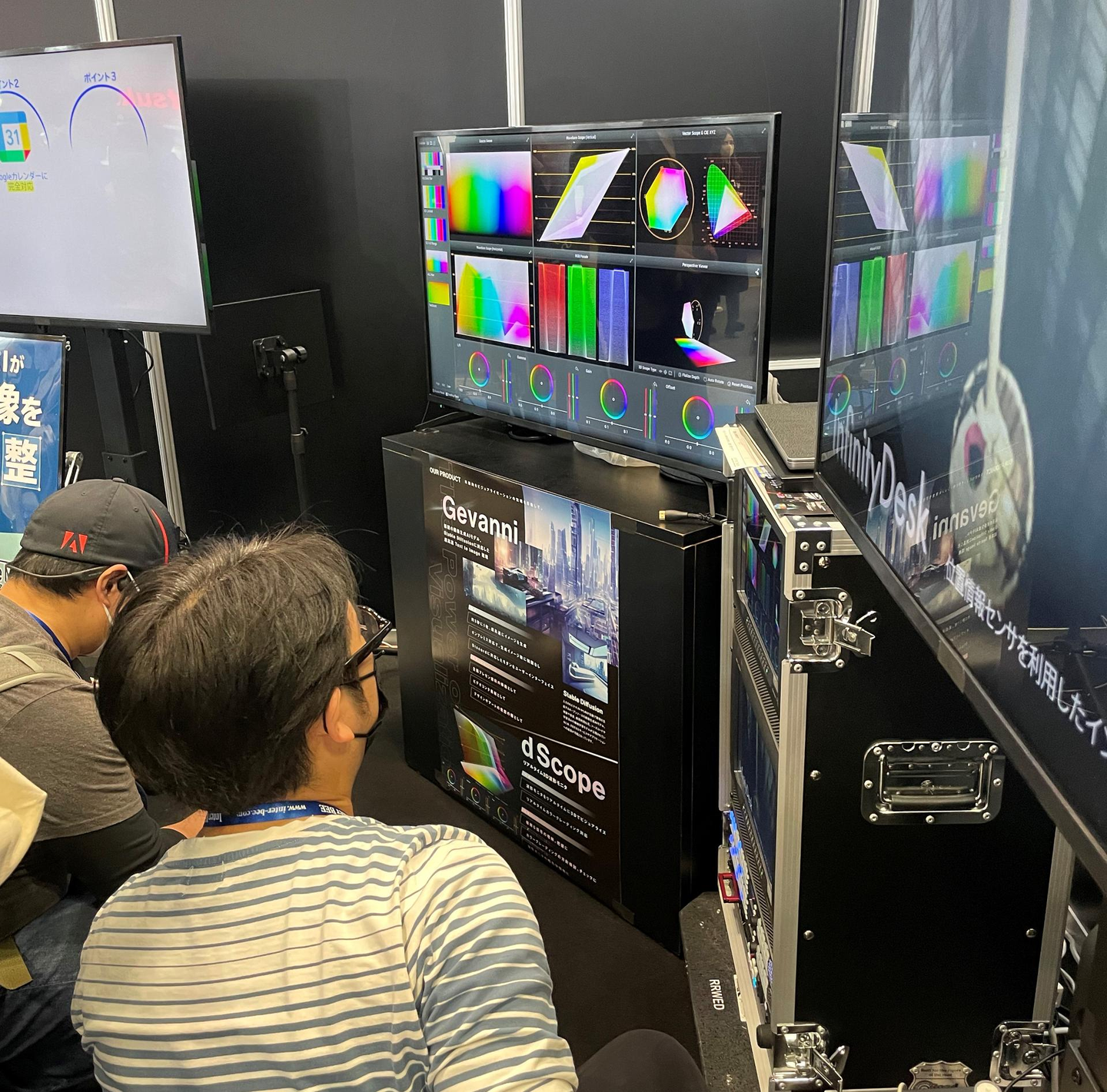

ーInterBEEでたくさんの方に体験して頂きましたが、反応はいかがでしたか?

「なるほど!」という良い反応を多数頂きました。むしろ波形モニタ自体を理解していて読める方に、特に感動して頂けたように感じています。

「波形モニタは理解していたつもりだったけど、こういうことだとは思わなかった」という方も、通常の2Dの波形モニタの状態から、奥行きをぐっと伸ばすところをリアルタイムでお見せすると、どういうことなのか理解しやすかったようです。

そもそも波形モニタに触れるのが初めての方もいらっしゃいましたが、dScopeがきっかけで知って頂けるのであれば、それはそれで良い機会をつくることができたかなと思います。

あとは通常波形というとウェーブフォームモニタですが、ベクトルスコープとCIEスコープも入れており、「ベクトルスコープを3D表示する」ことができるというレアな機能もあります。さらにカラーコレクション(カラコレ)機能も入れているので、さすがにこの組み合わせには「マニアックですね」と爆笑している方もいらっしゃいました(笑)。

ー実際に皆さんの声を聞くことができて、手ごたえを感じたようですね。

もともとは社内教育のために始めたものでしたが、実利的なアプリとして欲しいという声も頂き、もっと役立つものになる可能性を感じました。普段のワークの中でたまった知見をこういったプロダクト開発で活かしつつ、そこでの発見や副産物もまたワークに活かすなど、いい循環がつくれそうです。

リアルタイムで操作しながら読み方などについてご説明しました

幅広い可能性への足がかりとなる技術に、いち早く取り組む―超高速Text to Image 環境「Gevanni」

ー続いてはGevanniですね。こちらも企画の背景を教えてください。

時代の流れとして、ディープラーニング(機械学習の一種。AIなどのシステムが試行錯誤を繰り返し、最適化させ続けていく手法)を使ったものには何かしら取り組んでいく必要があると感じていました。ただし僕たちはエンタテインメントに近い領域のチームなので、社会的に「おもしろい」と感じられるアウトプットでなければ、仕事に繋がりにくいという課題もありました。

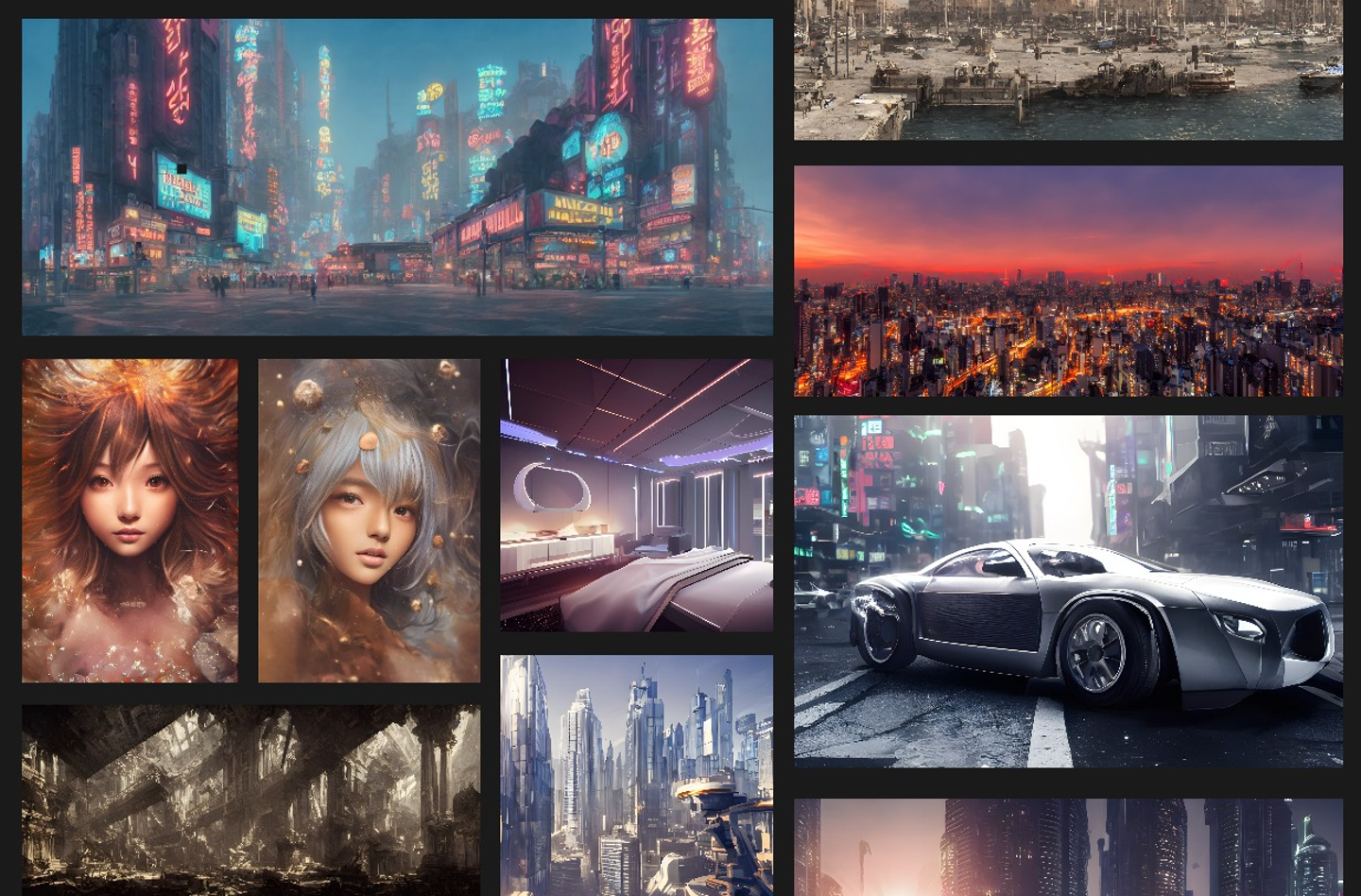

そんな中、今年に入ってからのAIによる画像生成分野の発展には著しいものがありました。画像というのは僕たちとも非常に近い領域で、ここには関わっていかなければということでつくったのが「Gevanni」です。

僕個人としても、これらの基になっている「拡散モデル」に関する論文を何年も前から眺めていました。2022年はMidjourneyに始まりDALL·E、StableDiffusionと、論文を眺める段階が終わり実際に使えるものが出てきた大きな進歩の年だったと思います。

ーMidjourneyが今年の2月に登場してからのスピード感には、目を見張るものがありましたよね。

Midjourneyは事前に全く情報がなかったわけではありませんが、その登場はかなり突然でした。実は先に論文を出していたのはDALL·Eだったのですが、Midjourneyがいきなり公開されたことでDALL·Eも公開せざるをえなくなった流れがあります。

この領域には問題もあるし、いろいろなことが“できてしまう”技術でもあるので、これまでみんな論文は公開してもモデルを公開することはなく、僕たちは指をくわえて待つしかなかったんです。それをMidjourneyがこじ開けたことでDALL·Eが登場し、そこから半年で登場したのがStableDiffusion。Midjourneyがきかっけ、StableDiffusionがゲームチェンジャーとなり、本当に世の中が大きく変化したと思います。

実際にGevanniで生成した画像

―Gevanniはどのようなプロダクトなのでしょうか?特徴を教えてください。

大きなポイントは「オンプレミス」であること。クラウドでもいいのですが、自分たちで自由に使えるモデルや環境をオンプレミスで持っておくことは非常に大切だと考えています。

理由のひとつはコスト面の問題です。例えばMidjourneyを法人で利用する場合、コーポレートプランとして年間600ドルを支払う必要があります。しかし、それを払っていてもファストモードを利用するには1枚毎にクレジットが減っていくため、結果的にさらに課金しなければいけません。StableDiffusionの公式Web環境であるDreamStudioも、クレジットを買う形になっています。でもそういった従量課金型の考え方だとたくさん試しづらいですよね。ハードウェアを持っていなければいけないし、電気代もかかりますが、それらを差し引いてもオンプレミスの方が適切だと考えました。

ふたつ目の理由は、表現の自由度が上がることでしょうか。僕たちの想定するニーズを満たすためには、各業界向け、各クライアント向けにチューニングした追加学習が可能な状態である方が適切だと考えました。

InterBEEでは、画像生成AIとはそもそもどんなものかを示しつつ、そういったモデルの最適化や追加学習などについても含めたデモンストレーションを行いました。企業のニーズがあるのであれば、それらを叶えられるものでなければビジネスにはなりませんからね。

ー会場で触ってみた方の反応はいかがでしたか?

これはオンプレミスの利点ですが、Gevanniはとにかく出力が速いんです。1枚あたり1秒を切って、平均0.98秒。その速さを体感していただけたと思います。

ーGevanniは今後、どのように展開していくのでしょうか?

そもそも「画像生成AI」といいますが、原理的にはこの技術は3Dモデルでも、音楽でも、何でも適用できるもの。その研究はものすごいスピードで進んでいて、来年にはほぼすべて網羅できてしまうのではないかと言われています。

だから、画像生成だけを見てこの技術の未来を決めてはいけないんです。それはあくまでわかりやすい適用例であり、とっかかりに過ぎません。

例えば今僕たちが考えているのは、音声信号からの字幕起こしに適用することです。ビデオ信号に重畳したり、フィルキーで吐けるようにしたり、少々ニッチなニーズではありますが、現状では対応できるものが無く且つ必要なものなので、やる意味があると感じています。このように、必ずしも画像生成だけの話ではなく、幅広い可能性へ繋がる足がかりとなる技術として捉えているんです。

「dScope」「Gevanni」をPRONEWSさまのYouTubeでご紹介いただきました

作品づくりのようにプロダクトに向き合う。その根底にある「ビジュアライズ」の視点

ーInterBEEではたくさんの反響を頂きました。自社プロダクトについて、今後どのように取り組んでいこうと考えていますか?

作品づくりのような感じでやっていけるといいなと思っています。まだまだ課題はたくさんありますが、チームメンバーにも推奨しています。みんなが作品ベースで始めつつ、プロダクトとしても考えられるようになっていけるといいですね。

実際にInterBEEに出展したことでテストもできたし、反応もわかったので、dScopeとGevanniはかなり進んだ感覚があります。こういった形で触れてもらえる場づくりは、今後も必要かもしれないですね。

ー今回の2つの自社プロダクトは、どちらもsync.devらしさを感じるものになっていました。sync.devとして、ワークだけでなく自社プロダクトにおいても重視していることはなんでしょうか?

僕たちはビジュアライズのチームなので、常にそこを軸に考えています。

ビジュアライズとは、単にかっこいいCGをつくることではありません。その言葉には「意味のあるものをつくりたい」という思いを込めており、そこに向かって進んでいくためには普通の映像制作とは異なるものが必要になります。

ビジュアライズという軸で考えていくと、適用範囲はユーザーインターフェースやインタラクションなど多岐に渡るため、アウトプットの種類を決めつけないことも重要です。映像からスタートしたチームではありますが、そこに固執することはありません。メディアに優劣はないし、それぞれに流行りもあれば、研究によって進化する部分もある。そうして進んでいく中でお互いにフィードバックをしあっています。そのため、広い視点でいろいろなものに興味を持って触れつづけることが大切なんです。

さまざまな分野や業界を見て、触れて、可能性を探る。そこにsync.devは全方位で取り組んでいます。もちろんすべてできているわけではないので、今回のInterBEEはその中間報告と思ってもらえればと思います。

会場まで足を運んでいただいたみなさん、ありがとうございました!

/assets/images/10217850/original/a3b629e9-3bdb-4634-9602-b5466bdd7c54?1661752946)