人事に公平性は本当に不可欠なのかーー。一瞬、ドキッとする問いです。だけど、そもそも完全に公平な人事なんて、ありえるのでしょうか? 「ピープルアナリティクス」(PA)について、科学技術社会論研究者の江間有沙さん、情報工学者の松原仁さん、独立研究家の山口周さん、そしてABEJAのメンバーが、語り合いました。議論の一部を紹介します。

まずはピープルアナリティクスについておさらい ABEJA古川: きょうのテーマは「ピープルアナリティクス」(PA)。「社員の人事データ、行動データを収集・分析し、人材活用のための知見を得る」ための手法についてです。ここ数年で企業における導入が広がっています =下図。

ご紹介した事例は採用領域が目立ちますが、タレントマネジメントや人材育成、退職抑制などの領域でもPAは使われています =下図。

PAで使われるデータは年齢・性別などの基本情報や、勤怠データ、パルスサーベイの結果などが一般的です =下図。

身体のデータをスマホやカード端末で集めてPAで使っている事例もあります =下図。

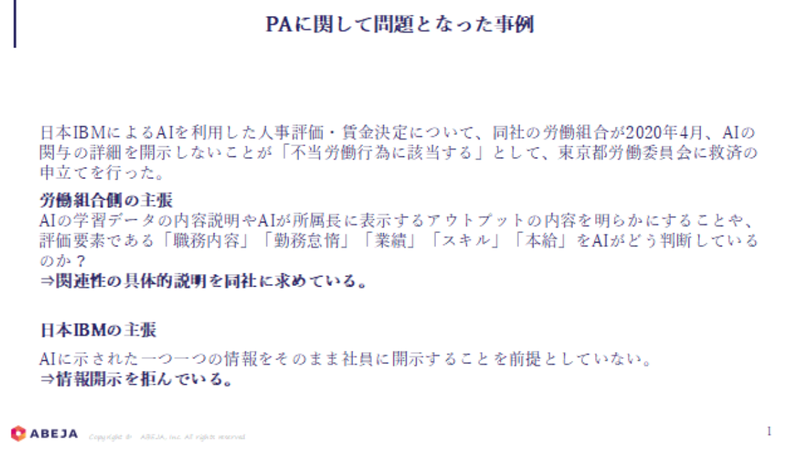

一方で、PAの導入に関連して、ブラックボックス化を背景に、労使間で争われた事例もあります =下図。

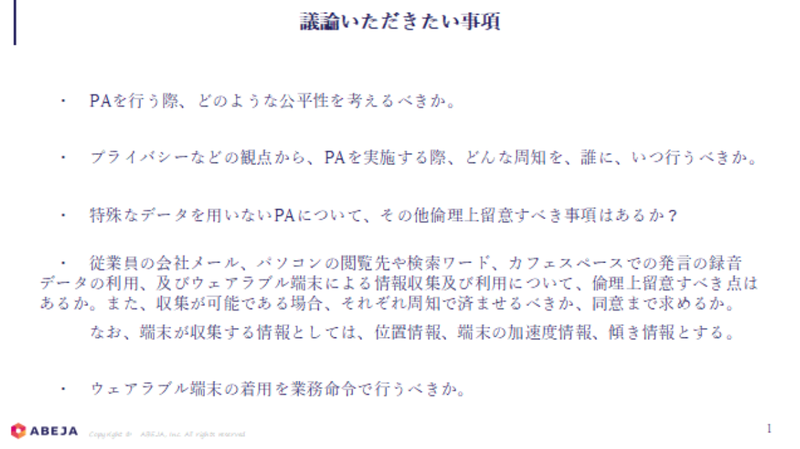

最後に、PAの開発初期の段階で踏まえておくべき課題の抽出やそのための視点について、本日議論いただきたいことを整理しました =下図。

ABEJA古川: まず、1つ目の論点として「公平性」について議論したいと思います。皆さんは、PAをするにあたり、どんな公平性を考えたらよいとお考えでしょうか。

次に、「従業員のプライバシー」について。従業員の会社メール、会社パソコンの閲覧や検索ワード、発言の録音などを、PAのデータとして使う企業もあります。これらのデータの使用は、法律上は問題ありませんが、個人のプライバシーを考慮する必要が出てきます。倫理に基づき、どんな周知や配慮が妥当でしょうか。これらのデータまでは使わないにせよ、通常のPAを運用するにあたり、公平性やプライバシーのほかに考慮するべき点についても、ご意見をいただければと思います。

また、こうしたデータの収集・使用に従業員が同意しない場合、業務命令を出してまで遂行するべきでしょうか。もちろんこうした行為に関し、適法か/違法かに関する法律上の論点は存在しますが、それ以外にももっと大きな視点にもとづいて検証すべき点はあろうかと思います。

日々の行動で分かる心身の不調 委員会の冒頭、飛び出したのは「月曜日のメール問題」と「トイレ問題」。人間がやっていることを人工知能に置き換えるにあたり、「人間がやっているから昰」とするのか、「それでも否」とするのかという議論に発展しました。

山口委員: まず、座を温めるための発言をさせていただきます。

哲学者ミシェル・フーコーは自著「狂気の歴史」で「アブノーマル」と「ノーマル」の境界を引くのは誰かと提起しています。彼曰く「病気」は自然に生まれるものではなく、権力者によって定義される、と。

たとえば、自閉症スペクトラムの診断数は、20年間で約30倍に増えました。これは生物学的要因によるものではなく、それまで「正常」だった人が「病気」と言われるようになったという背景がある。このように、「病気」と決める立場の者は非常に大きな権力を持つようになります。人事にも、これと似た側面があると思います。

人事の間で知られている、「月曜日のメール」問題と「トイレ」問題についてお話したいと思います。週明けのメールの返事が遅い人は心身に不調を抱えている可能性が高い。これが「月曜日のメール」問題です。「トイレ問題」は、職場にいるのが耐えられなくなって個室トイレに逃げ込む人が増え、個室のトイレが足りなくなってしまう現象を指しています。

内勤部署の場合、離席時間が長い従業員は心身に不調を抱えている可能性が高いことが統計データから見えてくるようになってきました。

こうしたことは多くの人事が知っていて、従業員の個別のケアをする時の参考情報にしているわけですが、これを仮にAIが判断して「AIによるとあなたは病気なので明日から休みなさい」なんて突然本人に言ったら、問題になるでしょう。

あえて極端な例を出しましたが、人間がやっていることを人工知能に置き換える時に「人間がやっているから昰」とするのか、「それでも否」とするのかは議論が必要だと思います。

また、偽陽性、偽陰性があることも踏まえた運用設計も必要です。例えば ソフトバンクは新卒採用の書類選考でAIを活用 していますが、AIが「合格」と判断したらそのまま合格にし、 AIが「不合格」と判断したら人間が見たうえで最終的に合否を判断しているそうです。

松原委員: 冒頭説明されていた 日立製作所のハピネスプロジェクト では、 社員にウェアラブル端末を着けてもらい行動調査 をしているのですが、1日何回、どのくらいの長さでトイレに行っているかが分かってしまうのはプライバシーの侵害ではないのか、という議論もありました。

一方、トイレの動向を把握したほうが、もしかしたら従業員の健康管理という面では会社にとってプラスかもしれません。長くこもっている従業員に産業医やカウンセラーと面談するよう勧めることができるかもしれませんし。逆にそのままに何もせずにいたら、従業員の心身の不調を会社が知りながら見逃していた、ということにもなりえます。どちらにしろ、非常にナイーブな問題なのですが。

山口委員: アカウンタビリティ(説明責任)を考え出すとキリがありませんね。例えば、健康状態をテストで判断することと、人工知能で判断することと、違いはどれほどあるのでしょうか。従来のテストも、その思想やロジックを説明しないのなら「ブラックボックス」と変わりはない。程度の差はあれ、従来のテストも人工知能も両方「ブラックボックス」といえると思うんです。

別の観点を。僕がいたヘイグループという企業は、優秀な人(ハイパフォーマー)はどんな行動様式を取るのか、「コンピテンシー」の概念に基づいて世界中で調査しました。

「コンピテンシー」とは能力のことだ、と誤解されがちなのですが、本来は、ある環境で刺激を与えた時の、反応システムのパターンをタイプ分けしたものです。

知能指数を変えることは難しいですがコンピテンシーは変えられます。ある状況で刺激を与えた時、いま「A」という反応のパターンを取っていたとして、「C」に変えてくださいと言った時に、比較的変えやすい。それがコンピテンシーの特徴です。

PAに関して、行動や振る舞いなど可塑性の高い要素をとってフィードバックすることは、本人の成長にとって示唆があると言えると思います。

一番典型的な話で言うと、「人の話を聞く」というのがあります。対話の際のデータをとって「平均で90%以上あなたが話し、相手が話した時間は10%前後しかありません」という結果が出た人がいるとします。優秀な成績を納めている人ほど自分が話す割合が50%に近いという統計があるので、「あなたはもう少し人の話を聞くようにしてください」と本人にフィードバックするとします。この行動は比較的変えやすいので意味がありますよね。

一方で、例えば見た目や声、生まれ持った気質など、本人の意思でコントロールできないことをフィードバックされてもどうすることもできません。

ですから、PAを議論する際、取得するデータが行動にまつわるデータなのか、それとも生理学的なその人の属性に近いデータなのかで、倫理に抵触する度合いも変わってくると思います。

何を「良いこと」として定義するべきなのか。また、画一的な指標をつくることは本当に個人や組織のためになるのかという指摘も。

山口委員: 先日「女性が入ると会議が長くなる」という発言がニュースになりましたが、多様性の研究によると、多様性が増すと会議は長くなることが統計的に裏付けられています。だから、女性が入る/入らない以前に、多様性が増すとコンセンサスに至る時間がかかるのは、当たり前に知られている事実です。

この場合、ある属性の人が会議に入ることで会議が長引く時に、それを「その人の問題」にするのか?逆に、「その人以外の人たちの問題」や「会議は短く終わるけれども多様性が低い会議の問題」を考えるべきです。そもそも、会議が長いこと自体をネガティブに考えるのかという論点もあると思います。

結論の出ない話で申し訳ないんですが、例えば、忖度なく意見を言うタイプの人が会議に入ると、会議は長引く。でも議論を尽くすことは、意思決定の品質を上げるという側面からすると、本来望ましいありかたです。

効果関数の取り方を「会議の時間」と取るか「意思決定の品質」と取るか、「コンセンサスのレベル」と取るか、実際に「実行された時の成否」と取るか。本質的な組織のパフォーマンスという観点なら、実行されてうまくいったか/いかなかったかだし、もうちょっと引き戻せば、意思決定の品質が高くて、みんなが「なるほど」と納得できて、腹落ちしているかどうかだし。

そこからどんどん引き戻して、会議の長さみたいな、測れるものを測って良し悪しを決めること自体に、一抹の不安はやっぱりありますね。

江間委員: なにを「良いこと」と評価するのかは重要な論点だと思います。 以前海外のウェブサイトで「仕事がダントツに速いが、余った時間にゲームをしている社員をクビにするべきか」という質問が投稿されたんですが、その際の答えの一つに「あなたは仕事ができて正直な従業員を解雇しようか悩んでいることになりますね」というコメントがありました。

「勤務時間にゲームをしている」という画一的な基準だけでNGを出すのではなく、個人として優秀な能力を持っているのだから、違う仕事を与えたり違う軸で評価をすることで、その人により活躍をしてもらうべきなのではないかという指摘です。

山口さんのコンピテンシーの話を聞いて思ったのですが、個人ごとに成長するポイントが違うなかで、どういう指標を作っていけると良いのでしょうか。

なんらか突出した部分がある人たちが漏れ落ちないものとするのか、全体の質を上げることを重視するのかによって、設計がずいぶん違うのではないかと思っています。

PAの対象となるテーマとして「採用」「育成」「離職予想と転職防止」などがありますが、特に個別性が高い「採用」と「育成」は取り扱いが難しいなと思いました。

ABEJA木下: わたしは人事として働いたり、コンサルタントとしてPAのプロジェクトを担当したことがありますが、「ハイパフォーマー分析」と「離職予想」の2つのテーマを比べた時、傾向が出やすいのは離職の方でした。なぜかと言うと、ハイパフォーマーはパラメータが多すぎて、そもそも傾向が出ないから、というのが私の所感です。一方、離職の場合は、パルスサーベイであまりよくない値を出していると離職しやすい印象があります。

人事に「公平性」はそもそも必要か 採用や評価にはどうしても恣意が介入してしまうもの。であるなら、そもそも公平である必要があるのか?恣意的ではいけないのか?ABEJAのメンバーから、そんな問いが出ました。

ABEJA山本: 論点が変わりますが、人事にそもそも公平性は必要なのか、という論点があると思っています。私自身は恣意的でいいという考えです。 評価は公平であるべきだという考えがある一方で、人が人を評価するのだから恣意的でいいではないか、という考えもある。機械がやったほうが客観的で公平だ、という意見も一定の理解を得られる気がします。

山口委員: プロテスタンティズムのなかには、カルヴァン派に代表されるように、神に救われるかどうかは、あらかじめ神によってすべて決まっているという「予定説」があります。救われる人は救われる、救われない人は救われない、神の好き嫌いで決まる、という考え方です。

ですが、神が好きな人だけ天国に行かせる時に、神は悪行に悪行を重ねた人間を気にいるでしょうか。

これを人事に置き換えて、「我が社の人事評価は上司の好き嫌いで付けます。上司も人間ですから頑張っている部下を普通は気に入るので、それで問題ないと思います」という考え方はありえると思います。普通の神経を持つ人なら、クライアントの問題を一生懸命考えているような部下を「可愛いな」と思うじゃないですか。

だから、「努力」と「恣意的な評価」はそんなに逆相関しないのではないでしょうか。恣意的な評価と「あの人は頑張って成果も出している」という評価の間に、果たしてどの程度の差が出てくるのかを考えるのは、なかなか興味深い論点だと思います。

これは極論ですし、こんな決め方では公平にはなりません。でも、公平性をできるだけ保とうとした結果、無色透明な組織になってしまうより、「この人が好きだからお互いに一緒に仕事をやってます」という方が、むしろパフォーマンスが出るかもしれませんね。

一方で、「絶対の公平性は実現できないので我が社は恣意的に評価します」と開き直っている企業よりも、「絶対の公平は実現できないかもしれないけれど、なるべく公平であろうと努力しています」という企業の方が、社員は「頑張ろう」と思うだろうとも思います。

ABEJA高橋: 人事の立場からすると、「公平性より納得感」だと思っています。

もちろん公平な評価は、評価制度の重要な目的です。ただ、人が人を評価する以上「完璧」はありえない。AIでやったとしても、どんなデータを使うのかで、なんらかの恣意性は発生します。大切なのは、評価の結果、個人が仕事に前向きになれたり、成長意欲を持てたりすること。そう考えると、仮にAIが評価に使われたとしても、最終的には人間が介入して対話する必要性は、まだまだあるような気がします。

AIを使うことで客観性を高めた結果として、「レッテル貼り」につながってしまう可能性も指摘されました。

江間委員: データとして外から見えるものを見ていると「取れるデータしか見ない」ことになります。一方で、これまた倫理的な問題があると思うんですが、思想や人への態度、考え方も、ある種データで取れるようにはなってきているようです。

このあたりは松原先生がお詳しいかもしれないですが。顔の表情などで「この人はどう考えているか」という、エモーショナルAIのような技術も出てきました。

感情を理解するAIを現実世界に適用する事例として、中国では様々な先進的な事例があり、同時に疑問も早い段階から提示されています。たとえば、数年前に 学校の教室に接地されたカメラが生徒の顔から感情を読み取ること に関して、中国国内でも監視化への恐れとして議論が起こったこともあります。

人の評価をAIでやったほうがむしろ客観的だしムラがないというのなら、あるいはそれが世界的な流れなのであれば、人事考課に導入してもいいのか。でも、それは冒頭で山口さんがおっしゃっていた「何が病的か」の再定義になりかねないようなところもある。

客観的に行うということは、カテゴリ化や型を作ることにもつながるので、レッテルを貼ることと同義ではあります。人間があやふやに言うだけならまだしも、機械的に当てはめて形式化していくと、問題のある扱い方もできるようになってくると思います。

(下に続く)

この記事は、ABEJAの倫理委員会「 Ethical Approach to AI 」での議論の一部を公開しています。AIを活用したソリューションやプロダクトを設計する過程で、倫理的な課題にぶつかることがあります。そんなとき、ABEJAでは、その課題について、様々な分野に詳しい委員会のメンバーに議論していただき、そこでの意見や知見を事業や開発に反映するよう努めています。 今回取り上げたのは「ピープルアナリティクス」。従業員に関する様々なデータを集めて分析、本人や組織が抱える課題を可視化し、解決へと導くための手法です。一方、集めるデータによっては、プライバシーや公平性に抵触することもあります。どういった点を踏まえるべきなのか、ご意見をいただきました。 文:錦光山 雅子・高橋 真寿美

(2021年7月30日公開の「テクプレたちの日常 by ABEJA」より転載)