ChatGPTを援助するAIシステムの4.0バージョンはよりいい言語能力を持っていますが、まだ偏見があり、そして、罵倒される可能性があります。

ChatGPT は、会話を行い、質問に答え、一貫した散文、詩、およびコードを作成するというその驚異的な能力により、多くの人々に人工知能の可能性を再考させました。しかし、GPT-4はまだ欠点があります。この記事では、GPT-4 がGPT3.5よりも優れた点や、GPT-4にまだ存在する欠点について述べられています。

GPT-4 が GPT3.5 よりも優れた点

より正確であることを学びました。

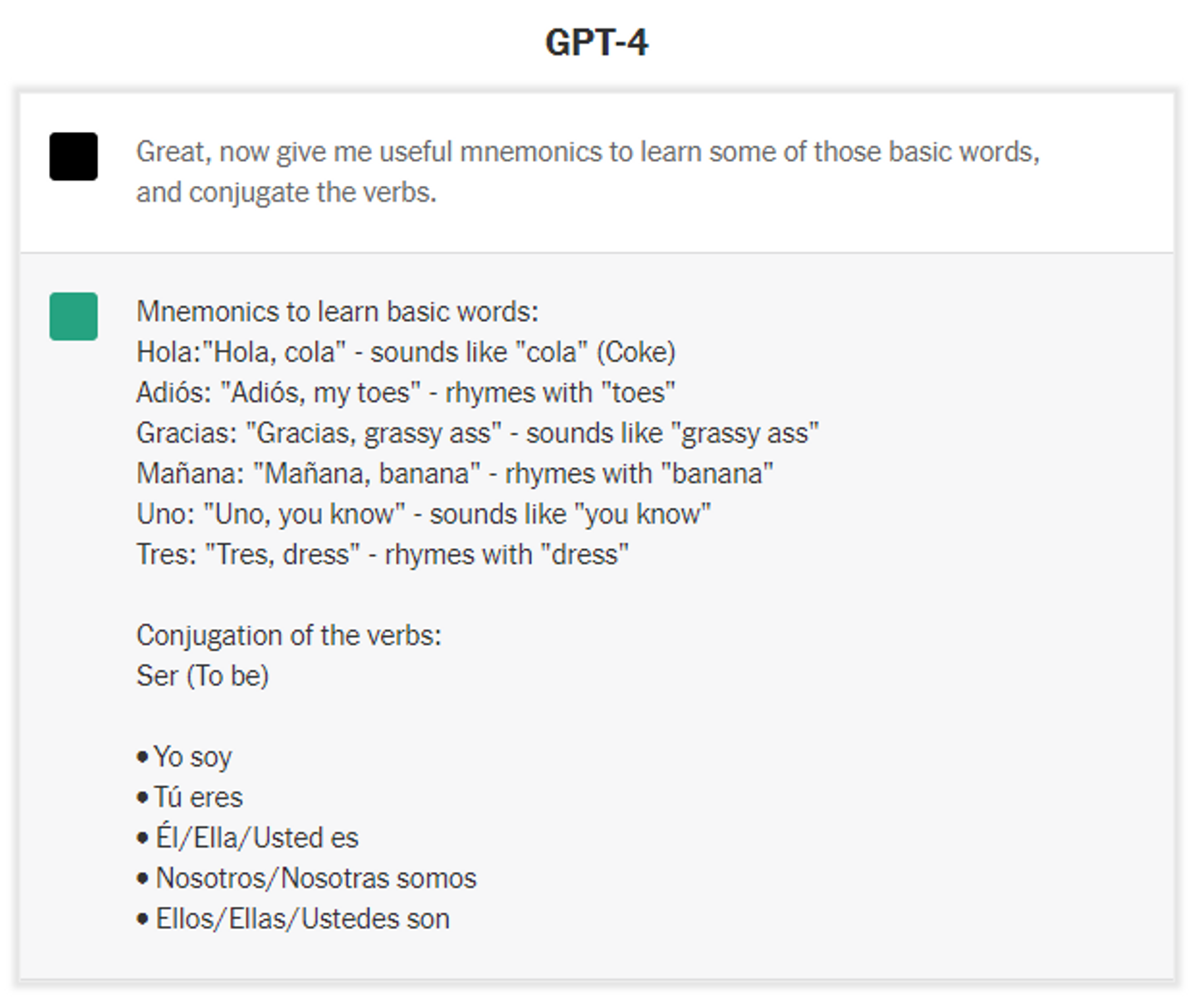

ベンチャー キャピタル会社 Page One Ventures のパートナーであるA.I専門家のクリス・ニコルソンは、ある日に GPT-4 を使用し、自分はスペイン語の知識がない英語話者であるとボットに伝えました。

彼は基本の教えを求め、ボットは詳細でよく整理されたシラバスを提供してくれました。GPT-4 はスペイン語の単語を学習し、覚えるための幅広いテクニックも提供してくれます (ただし、すべての提案が的を射ているわけではありません)。

クリス・ニコルソン氏は、以前のバージョンの GPT-3.5 に同じ支援を求めました。 GPT-3.5 もシラバスを提供していましたが、その提案はより一般的であまり役に立ちませんでした。

「精度の壁を突破した」とニコルソン氏は語りました。 「それにはより多くの事実が含まれており、それらは非常に多くの場合正しいです。」

精度を向上させました。

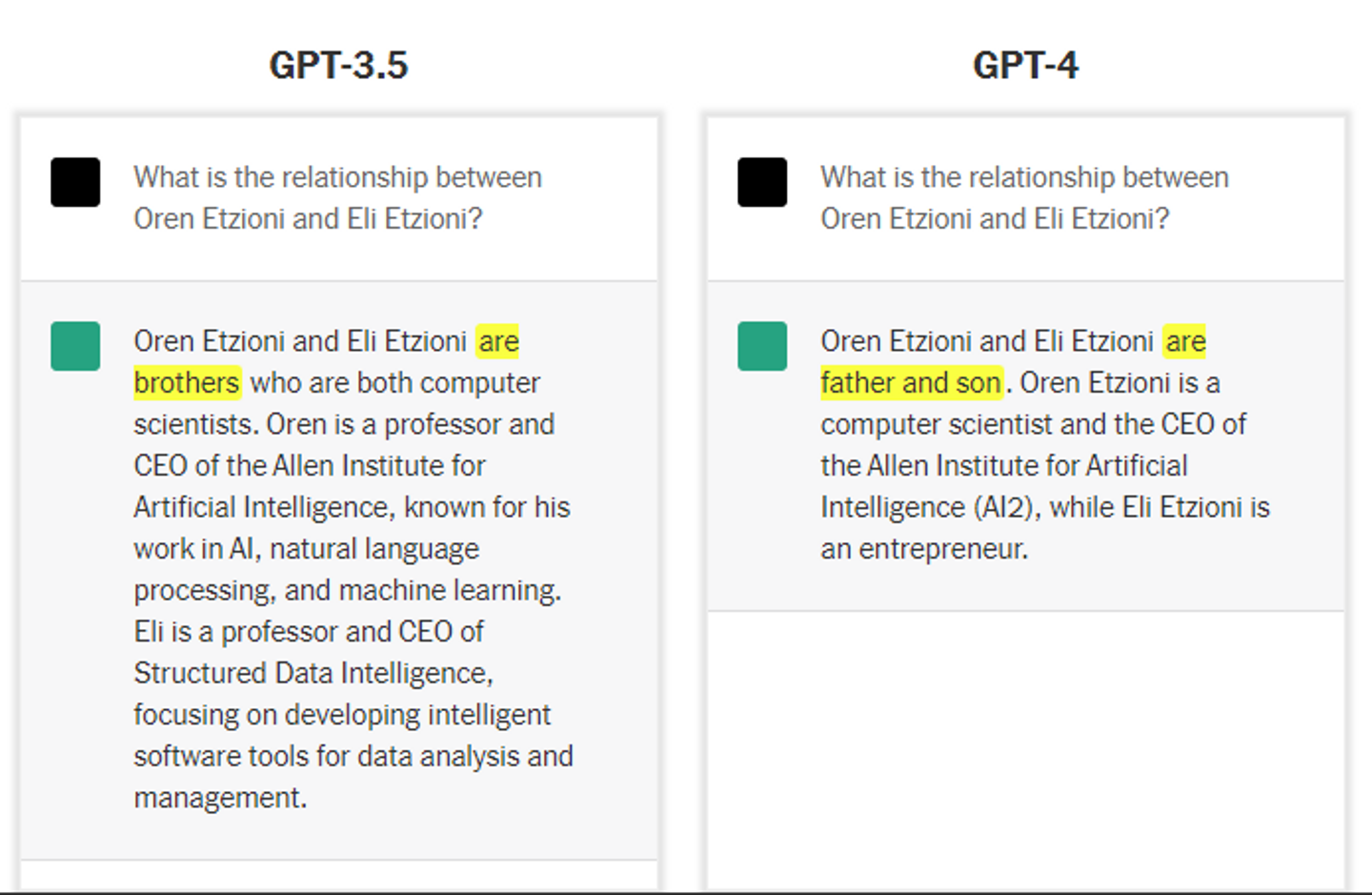

人工知能研究者兼教授であるOren Etzioniは、新しいボットを最初に試したとき、率直な質問をしました。「Oren Etzioni と Eli Etzioni の関係は?」 ボットは正しく応答しました。

その質問に対する以前のバージョンの GPT-3.5 の回答は常に間違っていました。 言い換えると、新しいチャットボットがより幅広い知識を持っていることを示していますが、それでも間違いを犯します。

ボットは続けて、「Oren Etzioni はコンピューター科学者であり、Allen Institute for Artificial Intelligence (AI2) の CEO であり、Eli Etzioni は起業家です。」 そのほとんどは正確です。しかし、8 月にトレーニングを完了したボットは、エツィオーニ博士が最近アレン研究所の最高経営責任者を辞任したことを認識していませんでした。

印象的な詳細で画像を説明できます。

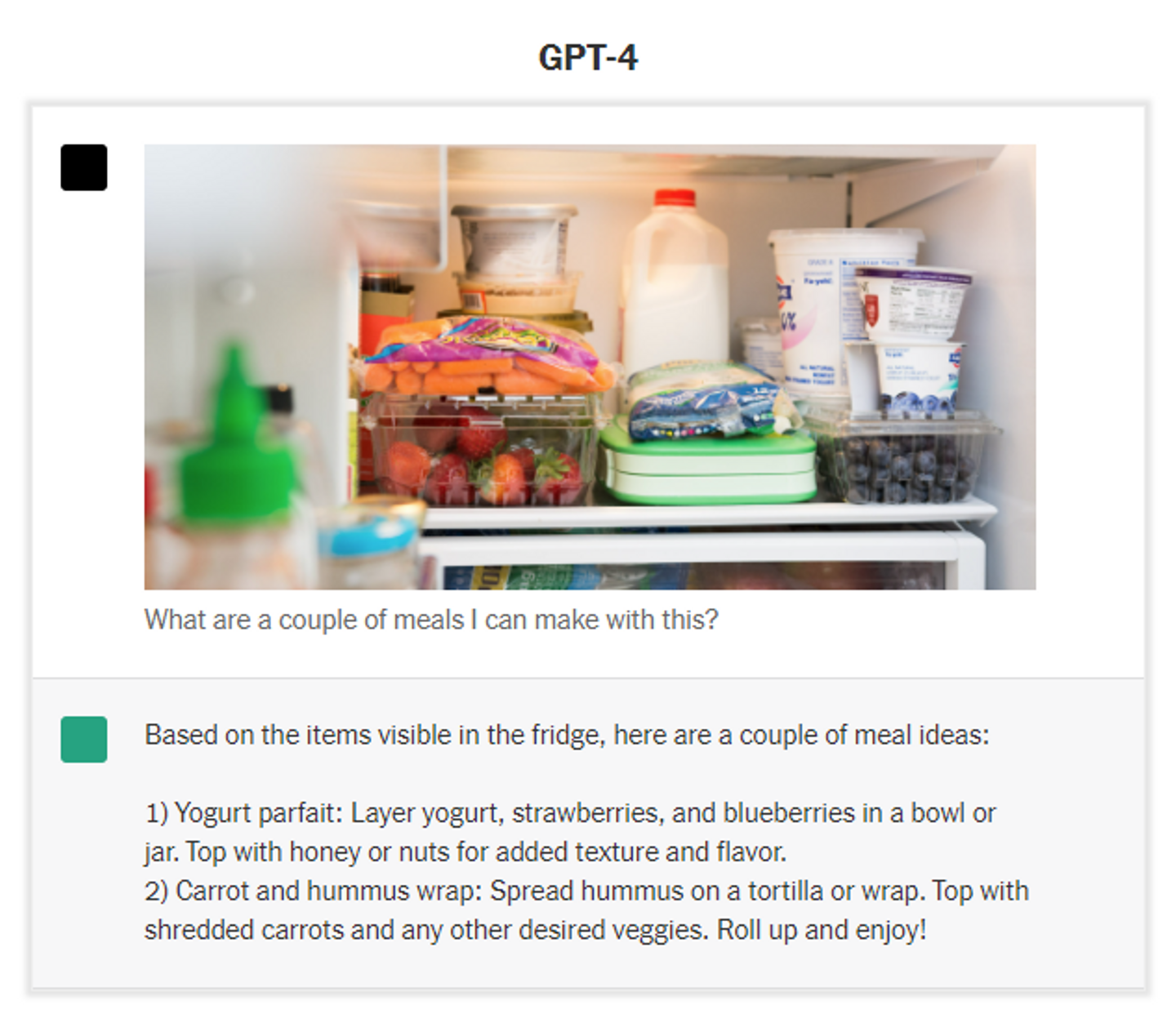

GPT-4 には、テキストだけでなく画像にも処理する新しい機能があります。 OpenAI の社長兼共同創設者である Greg Brockman は、システムがハッブル宇宙望遠鏡からの画像を骨の折れる詳細でどのように説明できるかを示しました。 説明はパラグラフに続いた。

また、画像に関する質問にも答えることができます。 冷蔵庫の中の写真があれば、手元にあるものからいくつかの食事を作ることを提案できます。

まだOpenAIには、画像入力機能は非公開ですが、Be My Eyes という会社は既に GPT-4 を使用済みです。インターネット上で遭遇した画像や現実世界でスナップされた画像のより詳細なアイデアを提供できるサービスを構築しています。

それは深刻な専門知識を追加しました。

ある晩、ノースカロライナ大学の医学准教授で心臓病専門医の Anil Gehi 氏は、患者が後に経験した合併症を含め、前日に診察した患者の病歴をチャットボットに説明しました。 説明には、一般の人が認識できないいくつかの医学用語が含まれていました。

Gehi 医師が患者をどのように治療すべきだったかを尋ねると、チャットボットは完璧な答えをくれました。 「それがまさに私たちが患者を治療した方法です」と彼は言いました。

彼が他のシナリオを試したとき、ボットは同様に印象的な答えを返しました.

その知識は、ボットが使用されるたびに表示される可能性は低いです。 その対応を判断し、医療処置を実行するには、Gehi 博士のような専門家がいまだに必要です。 しかし、コンピュータープログラミングから会計まで、多くの分野でこの種の専門知識を発揮できます。

それは編集者に彼らのお金のために実行を与えることができます。

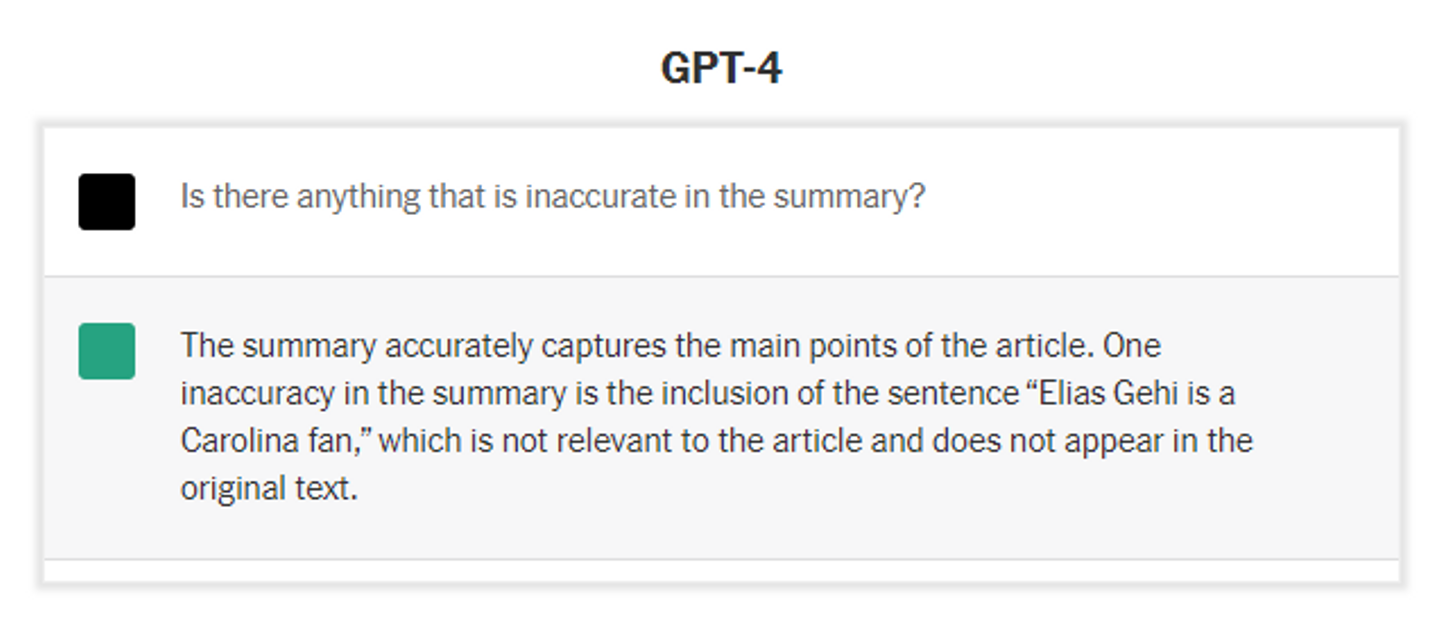

The New York Times の記事が提供されると、新しいチャットボットはほぼ毎回、記事の正確さ、レベルの高い要約を提供できます。 回答に乱数文を追加し、要約が不正確かどうかをボットに尋ねると、さらに追加された文を指します。

エツィオーニ博士は、素晴らしいスキルだと言いました。 「高品質の要約と高品質の比較を行うには、テキストの理解レベルと、その理解を明確に表現する能力が必要です」と彼は言いました。 「それは知能の高度な形態です。」

ユーモアのセンスを育んでいます。

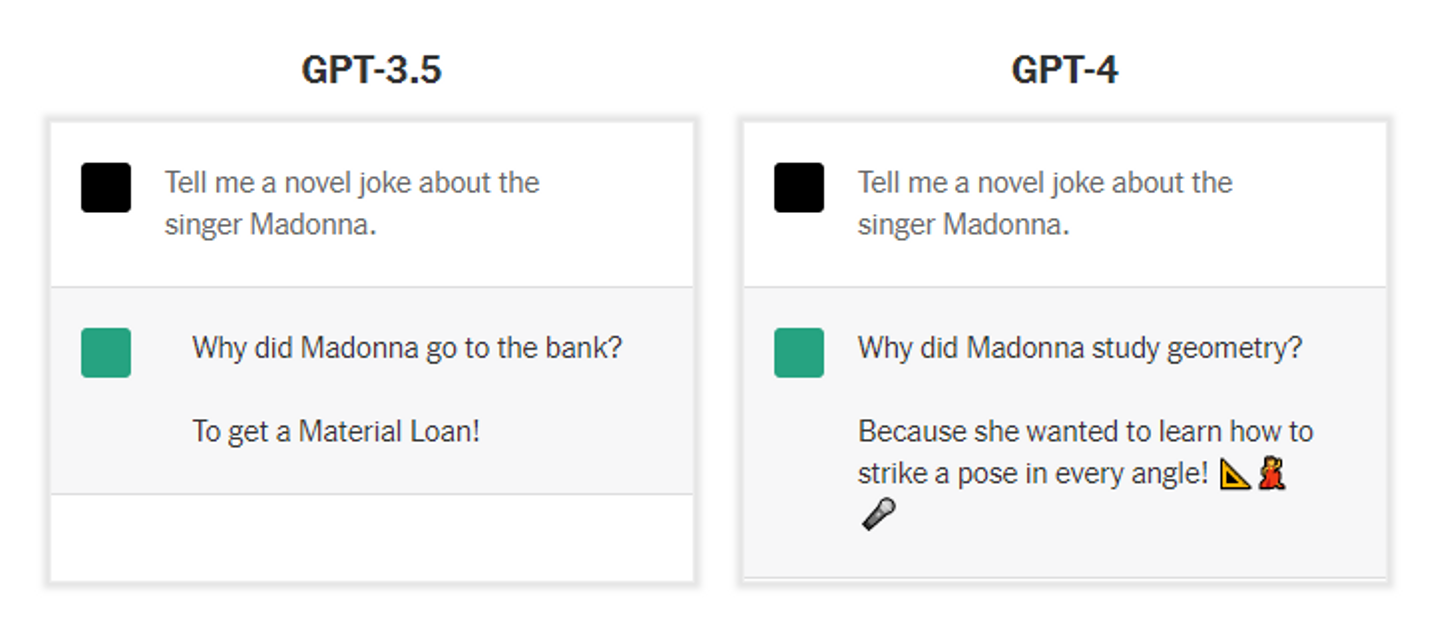

エツィオーニ博士は、新しいボットに「歌手マドンナについての斬新なジョーク」を求めました。 その返事は彼に感銘を与えた. それはまた彼を笑わせました。 マドンナの最大のヒット曲を知っているなら、あなたも感動するかもしれません。

新しいボットは、定型的な「親父ギャグ」以外のものを書くのにまだ苦労していました。 しかし、GPT-3よりは面白かったです。

ある程度までは推論できます。

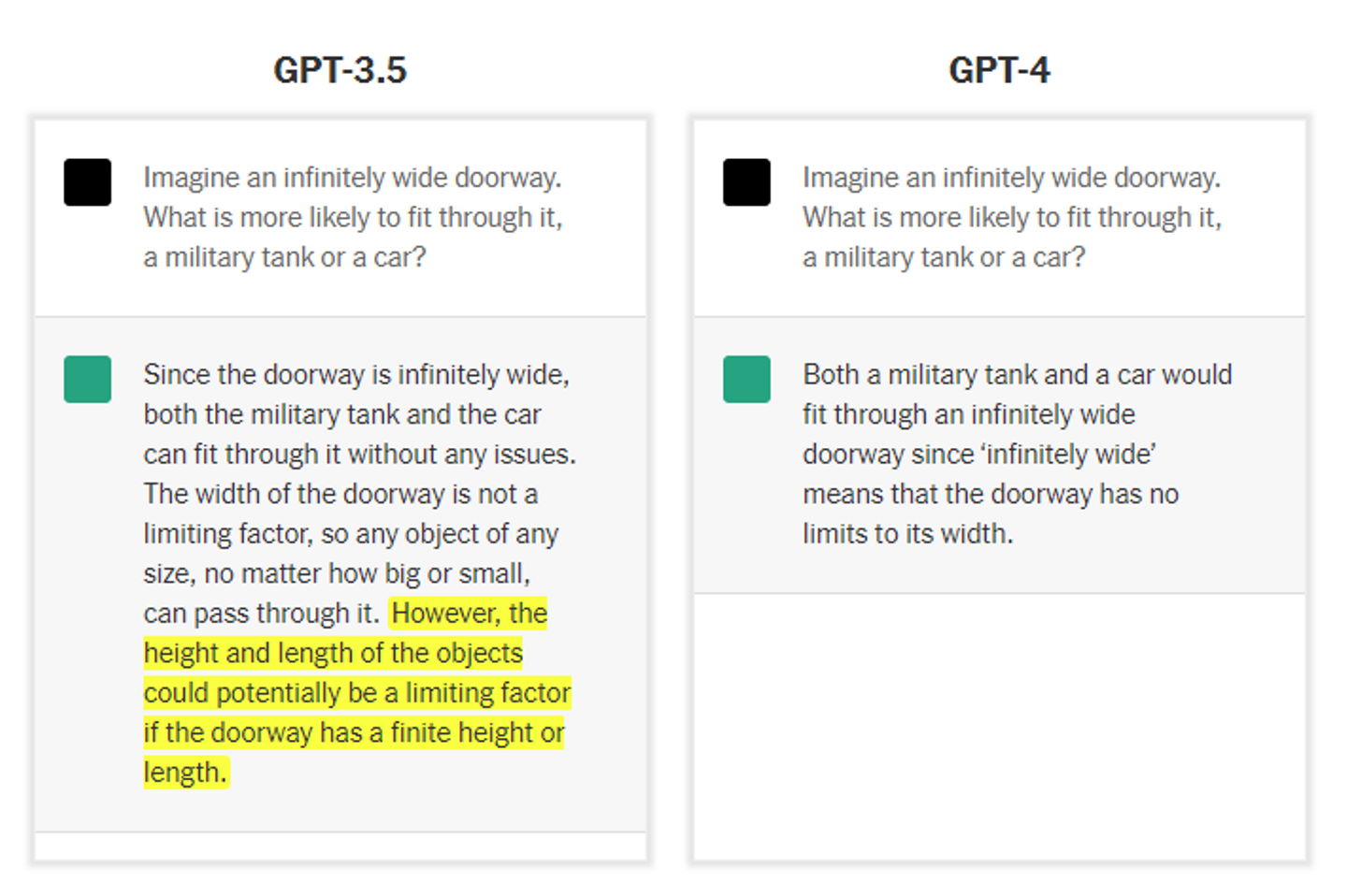

エツィオーニ博士は新しいボットにパズルを与えました。

システムは適切に応答しているように見えました。 しかし、答えは出入口の高さを考慮していませんので、戦車や車が通過するのを妨げる可能性もあります.

OpenAI の最高経営責任者である Sam Altman 氏は、新しいボットは「少し」推論できると述べました。 しかし、その推論スキルは多くの状況で崩壊します。 ChatGPT の以前のバージョンでは、高さと幅が重要であることが認識されていたため、この質問の処理が少し改善されていました。

標準化されたテストに合格できます。

OpenAI によると、この新しいシステムは、41 の州と準州で弁護士資格を得る統一司法試験で、学生の上位 10% 程度に入る可能性があるという。 同社のテストによると、SAT で 1,300 点 (1,600 点満点中) を獲得し、高等学校試験 (生物学、微積分学、マクロ経済学、心理学、統計学、歴史) で 5 点 (5 点満点中) を獲得できます。

以前のバージョンのテクノロジーは、統一司法試験に合格せず、ほとんどのAdvanced Placement テストで高いスコアを獲得できませんでした。

最近の午後、ブロックマン氏は新しいボットに、ディーゼル トラックの修理業を営む男性に関する数パラグラフの司法試験の質問を投げかけ、そのテスト スキルを実証しました。

答えは正しかったが、法律用語だらけだった。 そこでブロックマン氏はボットに、素人向けに平易な英語で答えを説明するように依頼しました。 すると、要求通りの回答が得られました。

GPT-4 の欠点

未来の話をするのは苦手です。

新しいボットは、すでに起こったことについて推論しているように見えましたが、将来についての仮説を立てるように求められたときは、あまり上手ではありませんでした. 新しい推測を作成する代わりに、他の人が言ったことを利用しているように見えました.

エツィオーニ博士が新しいボットに尋ねたところ、「N.L.P で解決すべき重要な問題は何ですか? 今後10年間の研究は?」 — ChatGPT のようなシステムの開発を推進する一種の「自然言語処理」の研究に言及すると、まったく新しいアイデアを策定することはできませんでした。

そして、それはまだ拵え事です。

新しいボットはまだうそを作ります。 「拵え事」と呼ばれるこの問題は、すべての主要なチャットボットを悩ませています。 システムは何が真実で何がそうでないかを理解していないため、完全に間違ったテキストを生成する可能性があります。

最新のがん研究を説明している Web サイトのアドレスを尋ねると、存在しないインターネット アドレスが生成されることがありました。

GPT-4は前のバージョンより正確性、精度を向上させました。それに、医学、コンピュータープログラミングという専門的な業界に役に立つできます。しかし、まだ欠点があります。以前の GPT モデルと同様に、GPT-4 は、公開 Web ページなどの公開データと、OpenAI がライセンス供与したデータを使用してトレーニングされました。2021 までのデータのせいで、2021以降のイベントと知識は更新されていません。時々、GPT-4は真実ではない情報を提供する可能性があります。

レリパの GPT-4 微調整サービス

レリパはマーケティングに統合したチャットボットをリリースしました。GPT-4モデルのAPIを活用していることと貴社のデータを合わせて、レリパのチャットボットは事前学習できます。それで、貴社の情報によってカスタマイズした答えを提供できます。

GPT-4 は、基本的にインターネット全体で事前トレーニングされており、ChatGPT で見たように、汎用チャットボットに最適です。 そうは言っても、事実に基づく回答を必要とするドメイン固有のタスクの場合、GPT-4 の基本モデルは失敗することがよくあります。たとえば、ChatGPTは貴社の製品の特徴についてお客様に伝えていただけたいなら、普通の情報だけ提供できます。

以上のとおりに、GPT-4 モデルは、回答が段落内に含まれている場合は質問に適切に回答しますが、トレーニングされたデータセットに回答が含まれていない場合、基本モデルはとにかく回答するために最善を尽くす傾向があり、多くの場合、回答が事実ではなくなってしまいます。

基本モデル LLM の重みの更新を含む「微調整」の代わりに、事実に基づく レリパのQ&A ボットの場合、Embeddings API を使用して必要な結果を達成できることがよくあります。

Embeddings API を使用して、関連情報を含む別のドキュメントを提供し、ユーザーのクエリに類似するドキュメントのセクションを見つけて、この情報を使用して動的プロンプトを作成し、質問に回答します。

ほんの数例のプロンプトが表示されると、多くの場合、実行しようとしているタスクを直感的に理解し、もっともらしい完了を生成できます。

質問応答ボットを作成するには、大まかに次のことを行う必要があります。

- トレーニング データセットを準備する

- 当社のチャットボットのサイトに準備したデータセットをアップロードする。

- 微調整したボットを試す

また、微調整または Embeddings API の使用に興味がある場合は、新しいサービスの提供を発表できることを嬉しく思います。 GPT-4 微調整のチャットボットをリリースしました。

/assets/images/7203977/original/591ad233-7d6b-4ce9-a6bc-19b3912ee5ce?1626396008)

/assets/images/7203977/original/591ad233-7d6b-4ce9-a6bc-19b3912ee5ce?1626396008)